Prova l'IA sul TUO sito web in 60 secondi

Guarda come la nostra IA analizza istantaneamente il tuo sito web e crea un chatbot personalizzato - senza registrazione. Inserisci semplicemente il tuo URL e guarda come funziona!

1. Introduzione: l'ascesa dell'intelligenza artificiale e i suoi confini in espansione

Ma dove dovremmo tracciare il confine? Man mano che l'IA diventa più autonoma, le implicazioni etiche, legali e sociali aumentano. Questo blog esplora i limiti dell'IA, i suoi rischi e come possiamo bilanciare innovazione e responsabilità etica.

2. Le capacità dell'intelligenza artificiale: fin dove siamo arrivati?

1. L'intelligenza artificiale nell'automazione e nel processo decisionale

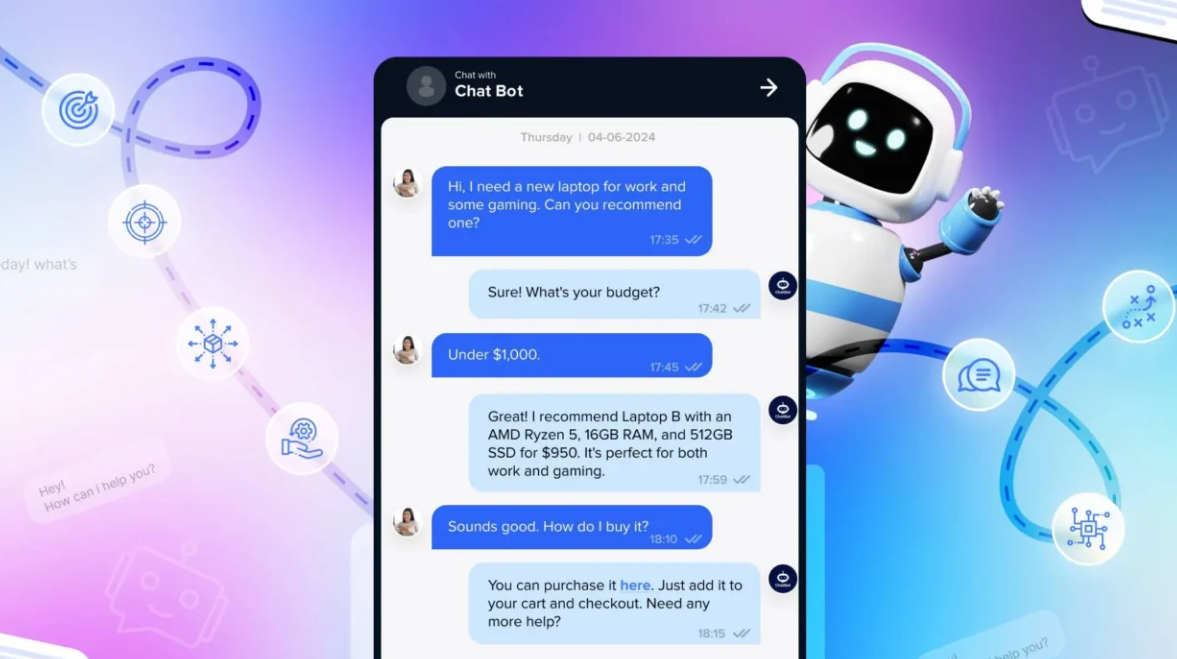

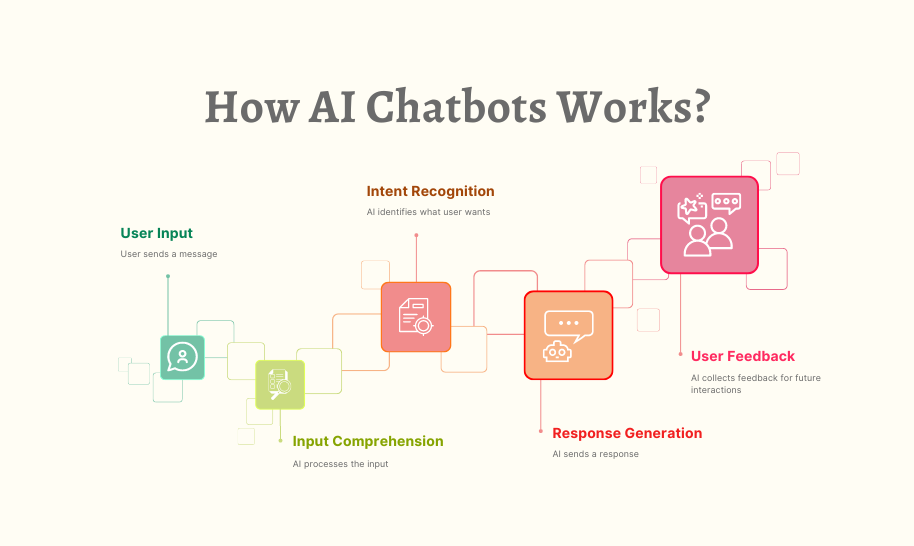

I sistemi basati sull'intelligenza artificiale automatizzano il servizio clienti, i processi delle risorse umane e le transazioni finanziarie.

L'analisi predittiva aiuta le aziende a prevedere le tendenze e ottimizzare le operazioni.

Gli algoritmi di intelligenza artificiale prendono decisioni in tempo reale in ambito sanitario, nella sicurezza informatica e nel trading azionario.

2. Intelligenza artificiale generativa e creatività

L'intelligenza artificiale crea arte, musica e contenuti scritti, confondendo i confini tra creatività umana e artificiale.

Gli strumenti di progettazione basati sull'intelligenza artificiale generano loghi, contenuti di marketing e persino sceneggiature cinematografiche.

I modelli di intelligenza artificiale aiutano nella ricerca scientifica, nella scrittura di codice e nel miglioramento dell'innovazione.

3. L'intelligenza artificiale nei sistemi autonomi

I veicoli a guida autonoma utilizzano l'intelligenza artificiale per la navigazione in tempo reale e il rilevamento di oggetti.

I robot basati sull'intelligenza artificiale vengono impiegati nella produzione, nell'esplorazione spaziale e nelle applicazioni militari.

Droni e sistemi di sorveglianza basati sull'intelligenza artificiale monitorano le operazioni di sicurezza e logistica.

3. I limiti etici dell'intelligenza artificiale: dove tracciamo il confine?

1. Intelligenza artificiale e sostituzione del lavoro: quando l'automazione è eccessiva?

L'intelligenza artificiale sta sostituendo i lavori nel servizio clienti, nella produzione e nell'analisi dei dati.

Mentre l'intelligenza artificiale aumenta l'efficienza, l'automazione di massa potrebbe portare a disuguaglianze economiche e perdita di posti di lavoro.

Governi e aziende devono investire in programmi di riqualificazione dell'intelligenza artificiale per bilanciare l'automazione con le opportunità di lavoro.

2. Pregiudizi ed equità dell'intelligenza artificiale: l'intelligenza artificiale può prendere decisioni imparziali?

I sistemi di intelligenza artificiale possono ereditare pregiudizi dai dati di formazione, portando a risultati ingiusti.

L'intelligenza artificiale distorta ha avuto un impatto sulle decisioni di assunzione, sugli algoritmi della giustizia penale e sulle approvazioni dei prestiti.

I quadri etici dell'intelligenza artificiale devono garantire equità, responsabilità e mitigazione dei pregiudizi nei modelli di intelligenza artificiale.

3. L'intelligenza artificiale nella sorveglianza e nella privacy: quanto è troppo?

Gli strumenti di sorveglianza basati sull'intelligenza artificiale tracciano gli individui, analizzano i comportamenti e prevedono modelli di criminalità.

L'intelligenza artificiale basata sul riconoscimento facciale è utilizzata dai governi per l'applicazione della legge e il monitoraggio della sicurezza.

Il confine tra sicurezza e privacy deve essere chiaramente definito tramite una rigida governance e normative sull'intelligenza artificiale.

4. L'intelligenza artificiale in guerra e nelle armi autonome

I sistemi di intelligenza artificiale militari possono identificare e colpire le minacce in modo autonomo.

L'uso dell'intelligenza artificiale in guerra solleva preoccupazioni morali sulla responsabilità e l'escalation involontaria.

Gli accordi internazionali devono regolamentare l'impiego dell'intelligenza artificiale nelle applicazioni militari.

5. Manipolazione dell'intelligenza artificiale e dei deepfake

I deepfake generati dall'intelligenza artificiale possono diffondere disinformazione, impersonare individui e manipolare l'opinione pubblica.

La manipolazione dei media basata sull'intelligenza artificiale minaccia le istituzioni democratiche e la reputazione personale.

I governi devono introdurre rigide normative sui contenuti generati dall'intelligenza artificiale per combattere l'uso improprio dei deepfake.

4. I limiti legali e normativi dell’IA

1. Regolamentazioni e governance globali dell'IA

L'EU AI Act mira a regolamentare l'utilizzo dell'IA in base alle categorie di rischio.

La U.S. AI Bill of Rights delinea i principi etici di sviluppo dell'IA.

I paesi stanno introducendo leggi sulla privacy dei dati (GDPR, CCPA) per regolamentare l'accesso dell'IA ai dati personali.

2. Etica dell'IA e responsabilità aziendale

Aziende come Google, Microsoft e OpenAI stanno definendo politiche etiche interne per l'IA.

La trasparenza dell'IA è fondamentale per garantire la responsabilità e prevenire applicazioni di IA dannose.

Le aziende devono istituire team di governance dell'IA per supervisionare l'implementazione etica dell'IA.

3. Definizione del ruolo dell'IA nella società

L'IA dovrebbe essere autorizzata a prendere decisioni che cambiano la vita in ambito sanitario, finanziario e di giustizia penale?

Quanto controllo dovrebbero avere gli esseri umani sul processo decisionale e sull'autonomia dell'IA?

È necessario definire con chiarezza dove l'intelligenza artificiale debba intervenire e dove sia invece richiesta la supervisione umana.

5. Trovare un equilibrio: come garantire uno sviluppo responsabile dell'intelligenza artificiale

1. Progettazione etica dell'IA e spiegabilità

Gli sviluppatori di IA devono dare priorità all'IA spiegabile (XAI) per rendere trasparenti le decisioni in materia di IA.

I principi etici dell'IA dovrebbero includere responsabilità, equità e non discriminazione.

2. Collaborazione uomo-IA anziché automazione completa

L'IA dovrebbe migliorare le capacità umane anziché sostituire completamente i lavoratori umani.

Le aziende dovrebbero implementare l'IA come strumento collaborativo, garantendo la supervisione umana nelle decisioni critiche.

3. Regolamentazioni rigorose sull'IA e cooperazione globale

I governi devono introdurre leggi che impediscano l'uso improprio dell'IA promuovendo al contempo l'innovazione.

La ricerca sulla sicurezza dell'IA dovrebbe essere finanziata per esplorare i rischi a lungo termine e le strategie di mitigazione.

4. Formazione sull'IA e adattamento della forza lavoro

I programmi di formazione e riqualificazione incentrati sull'IA dovrebbero preparare i lavoratori a carriere potenziate dall'IA.

Le aziende devono investire nella formazione etica e nella consapevolezza dell'intelligenza artificiale per i dipendenti e le parti interessate.

6. Conclusione: il futuro dell’intelligenza artificiale e i confini etici

Il futuro dell'intelligenza artificiale dipende da dove tracciamo il confine: bilanciando innovazione ed etica, automazione con occupazione e sicurezza con privacy. La chiave è uno sviluppo dell'intelligenza artificiale responsabile che dia priorità al benessere umano, all'equità e alla sostenibilità a lungo termine.

Mentre l'intelligenza artificiale si evolve, la domanda fondamentale rimane: come possiamo garantire che l'intelligenza artificiale serva l'umanità senza oltrepassare i confini etici e sociali?