Testa la TUA Azienda in Minuti

Crea il tuo account e lancia il tuo chatbot AI in pochi minuti. Completamente personalizzabile, nessuna programmazione richiesta - inizia subito a coinvolgere i tuoi clienti!

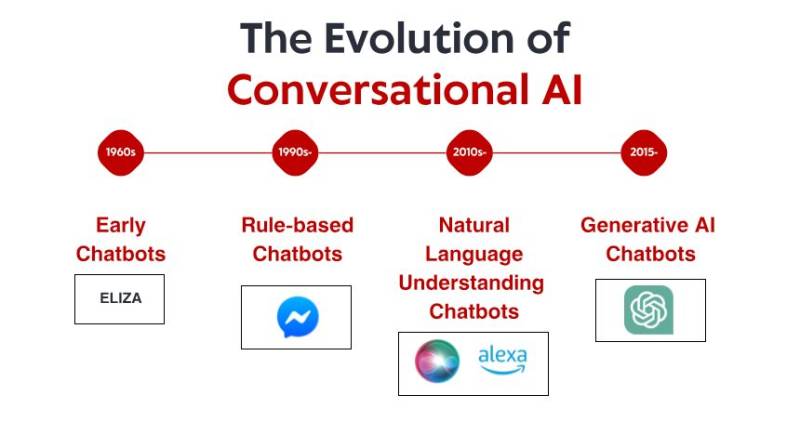

Gli umili inizi: i primi sistemi basati su regole

Ciò che rendeva ELIZA straordinaria non era la sua sofisticatezza tecnica – per gli standard odierni, il programma era incredibilmente elementare. Piuttosto, era il profondo effetto che aveva sugli utenti. Pur sapendo di parlare con un programma per computer senza alcuna reale comprensione, molte persone instauravano connessioni emotive con ELIZA, condividendo pensieri e sentimenti profondamente personali. Questo fenomeno, che lo stesso Weizenbaum trovava inquietante, rivelava qualcosa di fondamentale sulla psicologia umana e sulla nostra propensione ad antropomorfizzare anche le interfacce conversazionali più semplici. Per tutti gli anni '70 e '80, i chatbot basati su regole seguirono il modello di ELIZA con miglioramenti incrementali. Programmi come PARRY (che simulava uno schizofrenico paranoico) e RACTER (che "creò" un libro intitolato "La barba del poliziotto è mezza costruita") rimasero saldamente all'interno del paradigma basato su regole, utilizzando modelli predefiniti, corrispondenza di parole chiave e risposte preimpostate. Questi primi sistemi presentavano gravi limitazioni. Non erano in grado di comprendere il linguaggio, apprendere dalle interazioni o adattarsi a input inaspettati. La loro conoscenza era limitata alle regole definite esplicitamente dai loro programmatori. Quando gli utenti, inevitabilmente, si allontanavano da questi confini, l'illusione di intelligenza si infrangeva rapidamente, rivelando la natura meccanica sottostante. Nonostante questi limiti, questi sistemi pionieristici gettarono le basi su cui si sarebbe sviluppata tutta la futura intelligenza artificiale conversazionale.

La rivoluzione della conoscenza: sistemi esperti e informazioni strutturate

Sistemi esperti come MYCIN (che diagnosticava le infezioni batteriche) e DENDRAL (che identificava i composti chimici) organizzavano le informazioni in basi di conoscenza strutturate e utilizzavano motori di inferenza per trarre conclusioni. Applicato alle interfacce conversazionali, questo approccio ha permesso ai chatbot di andare oltre il semplice pattern matching verso qualcosa di simile al ragionamento, almeno in ambiti ristretti.

Le aziende hanno iniziato a implementare applicazioni pratiche come i sistemi di assistenza clienti automatizzati utilizzando questa tecnologia. Questi sistemi utilizzavano in genere alberi decisionali e interazioni basate su menu anziché conversazioni libere, ma rappresentavano i primi tentativi di automatizzare interazioni che in precedenza richiedevano l'intervento umano.

I limiti rimanevano significativi. Questi sistemi erano fragili, incapaci di gestire input imprevisti in modo efficiente. Richiedevano enormi sforzi da parte degli ingegneri della conoscenza per codificare manualmente informazioni e regole. E forse la cosa più importante era che non riuscivano ancora a comprendere appieno il linguaggio naturale in tutta la sua complessità e ambiguità. Ciononostante, quest'epoca stabilì concetti importanti che sarebbero poi diventati cruciali per la moderna intelligenza artificiale conversazionale: la rappresentazione strutturata della conoscenza, l'inferenza logica e la specializzazione di dominio. Si stavano preparando i terreni per un cambio di paradigma, sebbene la tecnologia non fosse ancora del tutto pronta.

Comprensione del linguaggio naturale: la svolta della linguistica computazionale

Questo cambiamento è stato reso possibile da diversi fattori: la crescente potenza di calcolo, algoritmi migliori e, soprattutto, la disponibilità di ampi corpora testuali analizzabili per identificare i modelli linguistici. I sistemi hanno iniziato a incorporare tecniche come:

Tagging delle parti del discorso: identificare se le parole funzionassero come nomi, verbi, aggettivi, ecc.

Riconoscimento di entità denominate: rilevare e classificare nomi propri (persone, organizzazioni, luoghi).

Analisi del sentiment: determinare il tono emotivo del testo.

Parsing: analizzare la struttura delle frasi per identificare le relazioni grammaticali tra le parole.

Una svolta degna di nota è arrivata con Watson di IBM, che ha notoriamente sconfitto i campioni umani nel quiz show Jeopardy! nel 2011. Pur non essendo propriamente un sistema conversazionale, Watson dimostrò capacità senza precedenti nel comprendere domande in linguaggio naturale, cercare in vasti archivi di conoscenze e formulare risposte: capacità che si sarebbero rivelate essenziali per la prossima generazione di chatbot.

Le applicazioni commerciali seguirono presto. Siri di Apple fu lanciato nel 2011, portando le interfacce conversazionali al grande pubblico. Pur essendo limitato per gli standard odierni, Siri rappresentò un progresso significativo nel rendere gli assistenti AI accessibili agli utenti comuni. Cortana di Microsoft, l'Assistente Google e Alexa di Amazon sarebbero seguiti, ognuno spingendo in avanti lo stato dell'arte dell'IA conversazionale rivolta al consumatore.

Nonostante questi progressi, i sistemi di quell'epoca avevano ancora difficoltà a gestire il contesto, il ragionamento basato sul buon senso e la generazione di risposte dal suono veramente naturale. Erano più sofisticati dei loro antenati basati su regole, ma rimanevano fondamentalmente limitati nella loro comprensione del linguaggio e del mondo.

Apprendimento automatico e approccio basato sui dati

Quest'epoca ha visto l'ascesa della classificazione degli intenti e dell'estrazione di entità come componenti fondamentali dell'architettura conversazionale. Quando un utente effettuava una richiesta, il sistema:

Classificava l'intento generale (ad esempio, prenotare un volo, controllare il meteo, riprodurre musica)

Estraeva entità rilevanti (ad esempio, luoghi, date, titoli di canzoni)

Associava queste ad azioni o risposte specifiche

Il lancio della piattaforma Messenger da parte di Facebook (ora Meta) nel 2016 ha permesso agli sviluppatori di creare chatbot in grado di raggiungere milioni di utenti, innescando un'ondata di interesse commerciale. Molte aziende si sono affrettate a implementare chatbot, sebbene i risultati siano stati contrastanti. Le prime implementazioni commerciali spesso frustravano gli utenti con una comprensione limitata e flussi di conversazione rigidi.

Anche l'architettura tecnica dei sistemi conversazionali si è evoluta durante questo periodo. L'approccio tipico prevedeva una pipeline di componenti specializzati:

Riconoscimento vocale automatico (per interfacce vocali)

Comprensione del linguaggio naturale

Gestione dei dialoghi

Generazione del linguaggio naturale

Sintesi vocale (per interfacce vocali)

Ogni componente poteva essere ottimizzato separatamente, consentendo miglioramenti incrementali. Tuttavia, queste architetture a pipeline a volte soffrivano di propagazione degli errori: gli errori nelle fasi iniziali si propagavano a cascata in tutto il sistema.

Sebbene l'apprendimento automatico abbia migliorato significativamente le capacità, i sistemi faticavano ancora a mantenere il contesto durante lunghe conversazioni, a comprendere le informazioni implicite e a generare risposte realmente diversificate e naturali. La svolta successiva avrebbe richiesto un approccio più radicale.

La rivoluzione del trasformatore: modelli linguistici neurali

Questa innovazione ha permesso lo sviluppo di modelli linguistici sempre più potenti. Nel 2018, Google ha introdotto BERT (Bidirectional Encoder Representations from Transformers), che ha migliorato notevolmente le prestazioni in diverse attività di comprensione del linguaggio. Nel 2019, OpenAI ha rilasciato GPT-2, dimostrando capacità senza precedenti nella generazione di testo coerente e contestualmente rilevante.

Il balzo in avanti più significativo è avvenuto nel 2020 con GPT-3, che ha raggiunto i 175 miliardi di parametri (rispetto agli 1,5 miliardi di GPT-2). Questo enorme aumento di scala, combinato con i perfezionamenti architettonici, ha prodotto capacità qualitativamente diverse. GPT-3 era in grado di generare testi straordinariamente simili a quelli umani, comprendere il contesto di migliaia di parole e persino eseguire attività per le quali non era stato addestrato esplicitamente.

Per l'IA conversazionale, questi progressi si sono tradotti in chatbot in grado di:

Mantenere conversazioni coerenti in diverse fasi

Comprendere query sfumate senza un addestramento esplicito

Generare risposte diversificate e contestualmente appropriate

Adattarne tono e stile all'utente

Gestire l'ambiguità e chiarire quando necessario

Il rilascio di ChatGPT alla fine del 2022 ha reso queste funzionalità accessibili al grande pubblico, attirando oltre un milione di utenti in pochi giorni. Improvvisamente, il grande pubblico ha avuto accesso a un'IA conversazionale che sembrava qualitativamente diversa da qualsiasi altra precedente: più flessibile, più competente e più naturale nelle sue interazioni.

Le implementazioni commerciali sono seguite rapidamente, con le aziende che hanno incorporato modelli linguistici di grandi dimensioni nelle loro piattaforme di servizio clienti, negli strumenti di creazione di contenuti e nelle applicazioni di produttività. La rapida adozione rifletteva sia il balzo in avanti tecnologico sia l'interfaccia intuitiva offerta da questi modelli: la conversazione è, dopotutto, il modo più naturale per gli esseri umani di comunicare.

Testa la TUA Azienda in Minuti

Crea il tuo account e lancia il tuo chatbot AI in pochi minuti. Completamente personalizzabile, nessuna programmazione richiesta - inizia subito a coinvolgere i tuoi clienti!

Capacità multimodali: oltre le conversazioni solo testo

Modelli di linguaggio visivo come DALL-E, Midjourney e Stable Diffusion hanno dimostrato la capacità di generare immagini da descrizioni testuali, mentre modelli come GPT-4 con funzionalità visive potevano analizzare le immagini e discuterle in modo intelligente. Questo ha aperto nuove possibilità per le interfacce conversazionali:

Robot per il servizio clienti in grado di analizzare foto di prodotti danneggiati

Assistenti alla vendita in grado di identificare gli articoli dalle immagini e trovare prodotti simili

Strumenti didattici in grado di spiegare diagrammi e concetti visivi

Funzionalità di accessibilità in grado di descrivere le immagini per utenti ipovedenti

Anche le funzionalità vocali hanno fatto notevoli progressi. Le prime interfacce vocali, come i sistemi IVR (Interactive Voice Response), erano notoriamente frustranti, limitate a comandi rigidi e a menu strutturati. Gli assistenti vocali moderni sono in grado di comprendere schemi vocali naturali, tenere conto di diversi accenti e difficoltà di linguaggio e rispondere con voci sintetizzate dal suono sempre più naturale.

La fusione di queste capacità sta creando un'intelligenza artificiale conversazionale realmente multimodale, in grado di passare senza soluzione di continuità da una modalità di comunicazione all'altra in base al contesto e alle esigenze dell'utente. Un utente potrebbe iniziare con una domanda testuale sulla riparazione della stampante, inviare una foto del messaggio di errore, ricevere un diagramma che evidenzia i pulsanti pertinenti e quindi passare alle istruzioni vocali mentre le sue mani sono impegnate nella riparazione.

Questo approccio multimodale rappresenta non solo un progresso tecnico, ma un cambiamento fondamentale verso un'interazione uomo-computer più naturale, incontrando gli utenti nella modalità di comunicazione più adatta al loro contesto e alle loro esigenze.

Generazione con recupero aumentato: fondare l'intelligenza artificiale sui fatti

La Retrieval-Augmented Generation (RAG) è emersa come una soluzione a queste sfide. Anziché affidarsi esclusivamente ai parametri appresi durante l'addestramento, i sistemi RAG combinano le capacità generative dei modelli linguistici con meccanismi di recupero che possono accedere a fonti di conoscenza esterne. L'architettura tipica di un RAG funziona in questo modo:

Il sistema riceve una query dell'utente

Cerca nelle knowledge base pertinenti informazioni pertinenti alla query

Invia sia la query che le informazioni recuperate al modello linguistico

Il modello genera una risposta basata sui fatti recuperati

Questo approccio offre diversi vantaggi:

Risposte più accurate e concrete basando la generazione su informazioni verificate

Possibilità di accedere a informazioni aggiornate oltre il limite di addestramento del modello

Conoscenza specialistica da fonti specifiche del dominio, come la documentazione aziendale

Trasparenza e attribuzione citando le fonti delle informazioni

Per le aziende che implementano l'intelligenza artificiale conversazionale, il RAG si è dimostrato particolarmente prezioso per le applicazioni di assistenza clienti. Un chatbot bancario, ad esempio, può accedere ai documenti più recenti sulle polizze, alle informazioni sui conti e ai registri delle transazioni per fornire risposte accurate e personalizzate che sarebbero impossibili con un modello linguistico autonomo.

L'evoluzione dei sistemi RAG continua con miglioramenti nella precisione del recupero, metodi più sofisticati per integrare le informazioni recuperate con il testo generato e meccanismi migliori per valutare l'affidabilità di diverse fonti di informazione.

Il modello di collaborazione uomo-intelligenza artificiale: trovare il giusto equilibrio

Le implementazioni di maggior successo oggi seguono un modello collaborativo in cui:

L'IA gestisce query di routine e ripetitive che non richiedono il giudizio umano

Gli esseri umani si concentrano su casi complessi che richiedono empatia, ragionamento etico o risoluzione creativa dei problemi

Il sistema conosce i propri limiti e, quando necessario, inoltra la richiesta agli agenti umani

La transizione tra IA e supporto umano è fluida per l'utente

Gli agenti umani hanno accesso al contesto completo della cronologia delle conversazioni con l'IA

L'IA continua ad apprendere dagli interventi umani, espandendo gradualmente le proprie capacità

Questo approccio riconosce che l'IA conversazionale non dovrebbe mirare a sostituire completamente l'interazione umana, ma piuttosto a completarla, gestendo le query semplici e di grandi dimensioni che consumano il tempo degli agenti umani, garantendo al contempo che le questioni complesse raggiungano le competenze umane appropriate.

L'implementazione di questo modello varia a seconda del settore. Nel settore sanitario, i chatbot basati sull'intelligenza artificiale potrebbero gestire la pianificazione degli appuntamenti e lo screening dei sintomi di base, garantendo al contempo la consulenza medica da parte di professionisti qualificati. Nei servizi legali, l'intelligenza artificiale potrebbe aiutare nella preparazione e nella ricerca di documenti, lasciando l'interpretazione e la strategia agli avvocati. Nel servizio clienti, l'intelligenza artificiale può risolvere problemi comuni, indirizzando al contempo problemi complessi ad agenti specializzati. Con il continuo progresso delle capacità dell'intelligenza artificiale, il confine tra ciò che richiede il coinvolgimento umano e ciò che può essere automatizzato si sposterà, ma il principio fondamentale rimane: un'intelligenza artificiale conversazionale efficace dovrebbe migliorare le capacità umane, piuttosto che semplicemente sostituirle.

Il panorama futuro: dove si sta dirigendo l'intelligenza artificiale conversazionale

Personalizzazione su larga scala: i sistemi futuri adatteranno sempre di più le loro risposte non solo al contesto immediato, ma anche allo stile di comunicazione, alle preferenze, al livello di conoscenza e alla storia relazionale di ciascun utente. Questa personalizzazione renderà le interazioni più naturali e pertinenti, sebbene sollevi importanti questioni relative alla privacy e all'utilizzo dei dati.

Intelligenza emotiva: mentre i sistemi odierni sono in grado di rilevare il sentimento di base, l'IA conversazionale del futuro svilupperà un'intelligenza emotiva più sofisticata, riconoscendo stati emotivi sottili, rispondendo in modo appropriato a disagio o frustrazione e adattando di conseguenza tono e approccio. Questa capacità sarà particolarmente preziosa nelle applicazioni di assistenza clienti, sanità e istruzione.

Assistenza proattiva: anziché attendere richieste esplicite, i sistemi conversazionali di nuova generazione anticiperanno le esigenze in base al contesto, alla storia dell'utente e ai segnali ambientali. Un sistema potrebbe rilevare che stai pianificando diverse riunioni in una città sconosciuta e offrire proattivamente opzioni di trasporto o previsioni del tempo.

Integrazione multimodale perfetta: i sistemi futuri andranno oltre il semplice supporto di diverse modalità, integrandole perfettamente. Una conversazione potrebbe fluire naturalmente tra testo, voce, immagini ed elementi interattivi, scegliendo la modalità giusta per ogni informazione senza richiedere una selezione esplicita da parte dell'utente.

Esperti di dominio specializzati: mentre gli assistenti generici continueranno a migliorare, assisteremo anche all'ascesa di un'intelligenza artificiale conversazionale altamente specializzata con una profonda competenza in ambiti specifici: assistenti legali che comprendono la giurisprudenza e i precedenti, sistemi medici con una conoscenza approfondita delle interazioni farmacologiche e dei protocolli di trattamento, o consulenti finanziari esperti in codici fiscali e strategie di investimento.

Apprendimento veramente continuo: i sistemi futuri andranno oltre la riqualificazione periodica, verso un apprendimento continuo dalle interazioni, diventando più utili e personalizzati nel tempo, pur mantenendo adeguate garanzie di privacy.

Nonostante queste entusiasmanti possibilità, permangono delle sfide. Le preoccupazioni relative alla privacy, la mitigazione dei pregiudizi, un'adeguata trasparenza e la definizione del giusto livello di supervisione umana sono questioni costanti che influenzeranno sia la tecnologia che la sua regolamentazione. Le implementazioni di maggior successo saranno quelle che affronteranno queste sfide in modo ponderato, offrendo al contempo un valore reale agli utenti. Ciò che è chiaro è che l'intelligenza artificiale conversazionale si è evoluta da una tecnologia di nicchia a un paradigma di interfaccia mainstream che media sempre più le nostre interazioni con i sistemi digitali. Il percorso evolutivo dal semplice pattern matching di ELIZA ai sofisticati modelli linguistici odierni rappresenta uno dei progressi più significativi nell'interazione uomo-computer, e il viaggio è tutt'altro che concluso.